Cette rentrée bien particulière ouvre une nouvelle année scolaire marquée par le « Grand Oral » auquel se soumettront les élèves de classe Terminale préparant les cinq épreuves finales du baccalauréat 2021. Les compétences orales évaluées relèvent d’une part de la capacité pour l’élève à prendre la parole en public, d’exploiter ses connaissances et d’autre part de développer une argumentation en lien avec son projet personnel. Les professeurs documentalistes sont doublement mobilisés à la fois pour la préparation et la participation au jury. Pour autant leurs actions menées au CDI, au sein des établissements scolaires et dans des cadres pédagogiques non formels participent de longue date de cette didactique de l’oral. Les activités dans leur diversité, les projets engageant les compétences en jeu dans le Grand Oral montrent une multiplicité d’entrées qui ne peuvent être réduites à ce seul domaine de « l’oral ». En effet, les apprentissages info-documentaires convoqués, la manière dont leur progression sont conçues relèvent pleinement du champ des oralités. Ce numéro de dossier se classe résolument dans cette perspective, celle d’expliciter, analyser des situations de communication, des actes de langage, en somme des faits culturels. Car chaque prise de parole évoque un contexte particulier : celui de l’oralité première aux situations de communication ordinaire, interpersonnelle, et celui de l’oralité seconde qui fait référence à un oral médiatisé et surtout relie l’écrit à l’oral pour reprendre la terminologie de Walter J. Ong. Ce dossier distingue au sein des pratiques professionnelles deux axes d’orientation qui par ailleurs se rejoignent souvent : l’enseignement de l’oral inscrit dans une démarche d’éducation aux médias et à l’information et plus globalement du développement la culture informationnelle et la pratique de l’oral dans une approche davantage communicationnelle faisant appel aux techniques du corps, à un art de dire et de parler.

Car comme l’évoque Sylvie Plane il ne s’agit pas d’enseigner un oral mais plutôt des oraux selon des cadres et enjeux de communication pluriels et de les extraire d’une représentation influencée par l’écrit. Elle souligne ainsi dans son approche historique toute la complexité du rapport entre l’Ecole et l’enseignement de l’oral oscillant entre maîtrise de la langue et maîtrise du discours. Ces objectifs de maîtrise s’articulent de manière fondamentale, essentielle avec ceux de l’éMI : les contributions d’Isabelle Martin et Blandine Schmidt interrogent les dispositifs médiatiques et analysent la démarche communicationnelle inscrite dans le dossier du CLEMI « se préparer à l’oral par la pratique médiatique », celle d’Emily Bouillon et d’Emeline Bis montre bien comment une classe media permet de travailler des apprentissages de maîtrise de la langue, de prise de parole, de connaissance des médias grâce à l’animation d’une webtv par les élèves. Stéphanie Quattrociocchi expose l’intérêt double de l’expérimentation du LabAurascope autour de l’enseignement de l’oral, à la fois pour l’élève et pour l’enseignant grâce à la vidéoscopie. Autant de lectures qui éclairent la démarche proprement info-documentaire des pratiques pédagogiques autour de l’oralité.

Bien parler selon des contextes variés relève également du développement de compétences psychosociales, d’estime de soi, de confiance, de compréhension de codes culturels, de signes pour bien argumenter ses propos, être capable de redonner voix à un texte par une interprétation juste, personnelle et donc par le fait de comprendre et de s’approprier une voix autre. Dans l’entretien qu’il nous a accordé, Cyril Delhay, auteur du rapport éponyme explicite son dessein politique de faire de l’apprentissage de l’oral un levier d’égalité des chances. Cette réactualisation, dans les programmes scolaires, de la nécessité de développer les compétences orales des jeunes adolescents fait écho au pouvoir que la parole maîtrisée donne. En reprenant son propre parcours il nous livre les clés de son enseignement d’un art oratoire, ce qui entre en résonance avec les déambulations jansoniennes proposées par Martine Liagre, la pratique du booktube selon Djamila Aït Hammi, la participation à des concours de lecture à voix haute conduite par Cécile Combettes. Virginie Seba, professeure documentaliste, slameuse, poète, nous fait partager la part sensible de son propre enseignement dans une dernière étape de ce voyage en oralité(s).

Au printemps dernier des voix se sont tues dans les théâtres, salles de spectacle vivant… peu de temps cependant pour reprendre par d’autres voies médiatisées, du podcast jusqu’au simple téléphone permettant des consultations poétiques avec pour mot d’ordre « Tenir parole ». Gageons que la lecture de ce numéro vous accompagne dans vos expérimentations par-delà les conversations masquées, la distanciation sanitaire, pour permettre aux élèves de « tenir parole » à leur tour.

PMB, un retour d’expérience

Pourquoi passer à PMB ?

On peut légitimement se poser la question lorsque le logiciel documentaire utilisé dans son établissement est BCDI, qu’il fonctionne bien, et qu’on en est plutôt satisfait.

Il faut savoir qu’il y a d’abord un aspect de conformité à une circulaire de 2012, la circulaire Ayrault, qui a pour but de favoriser l’usage du logiciel libre dans les administrations publiques, dont l’école fait partie. Choisir PMB est alors un moyen de se conformer à cette demande, au même titre que choisir l’utilisation de la suite bureautique Libre Office plutôt que celle de Microsoft.

Ensuite, il faut avoir en tête le modèle économique de Canopé pour BCDI : c’est un opérateur de l’État qui reçoit des subventions de ce dernier ; il est par ailleurs subventionné par chaque académie où il est implanté et chaque établissement doit payer annuellement la solution documentaire BCDI pour pouvoir l’utiliser, un abonnement dont le montant n’a fait qu’augmenter ces dernières années.

On peut donc décider de continuer à utiliser le logiciel de Canopé ou d’en changer pour faire des économies, économies non négligeables quand le paiement du logiciel est pris sur les lignes budgétaires attribuées au CDI.

Enfin, PMB peut permettre une gestion partagée des documents, inscrite dans une démarche de politique documentaire, pensée à l’échelle de l’établissement. Il offre également beaucoup de petites fonctionnalités bien pratiques au quotidien : le bulletinage assisté, le prêt express ou encore la gestion des « paniers » que je détaillerai au fur et à mesure de ce retour d’expérience.

Il y a beaucoup d’étapes à suivre pour utiliser PMB quand on n’a aucun accompagnement de la part de l’académie, mais c’est un changement qui, de mon point de vue, présente beaucoup d’avantages, dont le « multitâche » proposé par le logiciel (cataloguer et prêter un livre en même temps, par exemple).

Présentation générale

PMB est un logiciel documentaire développé par PMB services, il est complètement libre et gratuit, si tant est qu’on ne fasse pas appel aux services techniques de l’entreprise (maintenance, hébergement, formations, etc.) et s’installe sur un serveur. Cet outil est doté d’une interface de gestion et d’un catalogue, le tout accessible depuis n’importe quel navigateur web.

Avant de détailler l’utilisation de PMB, précisons quelques points pratiques

Vocabulaire de PMB

Les emprunteurs : dans PMB on parle de « lecteurs » pour désigner les personnes (élèves, enseignants, personnel autre…), usagers-emprunteurs des documents catalogués ; à ne pas confondre avec « utilisateurs », terme retenu pour désigner les personnes qui ont accès à la partie gestion ;

Le catalogue : le terme couramment utilisé est « OPAC » pour Open Public Access Catalog ;

Les recherches en mode gestionnaire : c’est principalement la « recherche multi-critères » qui est utilisée, elle s’apparente aux équations de recherche de BCDI.

Spécificités de PMB

Une première spécificité est l’organisation générale des menus : on trouve un premier menu horizontal avec différents onglets qui peuvent être ouverts dans différentes fenêtres du navigateur (circulation, catalogue, administration, portail…). Puis pour chaque menu, un sous-menu vertical qui permet différentes actions (sous l’onglet circulation par exemple, on peut prêter, rendre un ouvrage, créer de nouveaux lecteurs, etc.). Et enfin un sous sous-menu précisant les actions spécifiques au sous-menu (c’est très souvent le cas pour le menu de l’administration).

Une autre spécificité de PMB est la présence de « paniers » : ils permettent d’enregistrer certains ouvrages en fonction de critères et d’appliquer des actions sur l’ensemble des ouvrages présents à l’intérieur du panier (je reviendrai sur ce point).

Outil à maîtriser en complément de PMB

Un tableur : utile pour l’import de la base élèves.

Comment passer de BCDI à PMB ?

Si vous avez la chance d’être dans une académie qui propose ce logiciel, rien de plus facile, il suffit de contacter les services de la DANE1 ou le « groupe PMB » de votre académie pour faire la demande d’ouverture de base et il ne vous restera plus qu’à faire la « bascule » seul ou avec vos services académiques.

Si, en revanche, vous n’avez pas cette chance, cela est un peu plus complexe (et je parle en connaissance de cause…) : il faut procéder à un nettoyage de la base BCDI pour préparer la bascule, faire l’installation technique de PMB sur un serveur (en ligne ou en interne), vérifier les paramètres de PMB et procéder à la bascule.

Voici les tutos que j’ai utilisés et ma réflexion sur la future base PMB de mon établissement en rapport avec chacune des étapes mentionnées ci-dessus.

Étape 1 : Nettoyage de BCDI pour préparer la bascule vers PMB

TUTO 1 : Préparer la base BCDI (Alain Soulier2)

Une base PMB se réfléchit en amont : manière dont on veut que les documents apparaissent, modalités de prêt en fonction des ouvrages (manga, périodiques, BD, roman…), utilisation de douchette ou non pour les codes exemplaires… Toute la procédure est expliquée par Alain Soulier dans un tutoriel. Libre à chacun ensuite de réaliser sa propre organisation.

Pour ma part, j’ai d’abord choisi de faire en sorte que les « étagères3 » correspondent physiquement aux documents que j’ai au CDI : fictions, documentaires et périodiques. Puis, pour chacune de ces étagères, j’ai précisé à l’aide des « rayons » les différentes catégories : dans les fictions, on trouve les romans, les BD, les mangas, les nouvelles, les poésies… ; dans les documentaires, les différentes classes Dewey ; et dans les périodiques les différents abonnements du CDI.

Cette organisation permet aux élèves qui consultent le catalogue de se « balader » dans un CDI virtuel qui correspond à l’organisation physique du lieu. Ainsi ils ne sont pas « perdus » quand ils doivent aller chercher dans les rayons le(s) livre(s) qui les intéresse(nt).

J’ai profité de ce changement de logiciel documentaire pour « remettre à plat » les numéros d’exemplaires en mettant des codes-barres, lisibles avec une douchette. Il m’a donc fallu veiller à ce que les numéros d’exemplaires de BCDI puissent se fondre avec ce nouveau système. Une fois cette manipulation réalisée, il ne reste qu’à effectuer les changements dans PMB et à équiper les livres en codes-barres pour faciliter le prêt.

Cette première étape est importante, tout comme il est important de consacrer du temps à la préparation de BCDI. Essayez d’engager cette réflexion au moins une année avant de procéder au changement : pour ma part, j’ai consacré 40 h au moins de travail « pur » à cette phase préparatoire, en plus des heures de cours, de l’accompagnement des élèves au fil des journées et de toutes nos autres tâches. Essayez également de préserver des heures sans élèves dans votre emploi du temps ou, si vous êtes deux en poste, des plages horaires dédiées pendant lesquelles vous pourrez vous isoler (prévoyez en moyenne au moins 2 h consécutives).

C’est un travail de longue haleine, mais cela en vaut la peine !

Étape 2 : Installation technique de PMB

TUTO 2 : PMB Normandie

C’est la partie la plus complexe quand on doit installer PMB « seul », sans l’aide des services de l’académie. Nous n’avons pas tous les compétences et les connaissances pour faire face aux différents problèmes techniques.

Dans mon collège, le Principal m’a fait confiance pour installer en local PMB sur le serveur de l’établissement : j’ai suivi le tutoriel de PMB Normandie qui propose un déroulé pas à pas pour ce genre d’installation. Vous pouvez suivre ce même tuto pour installer PMB sur vos postes informatiques, mais cela suppose que tous les ordinateurs (au moins ceux du CDI) soient en réseau pour que les élèves puissent accéder au catalogue.

Je tiens à préciser que les collègues qui se lancent dans l’aventure risquent d’être amenés à résoudre des questions techniques (PHP4 , SQL5 notamment) et qu’il vaut mieux s’armer de patience pour parvenir à installer une base PMB accessible et fonctionnelle.

Étape 3 : Vérifier les paramètres de PMB (phase de test)

TUTO 1 : Préparer la base BCDI (Alain Soulier)

Avant de commencer à importer les données (ouvrages et élèves), il est nécessaire de faire le point sur les paramètres de PMB et de vérifier les imports.

Première étape : nettoyer la base que vous avez installée, parfois les versions PMB et leur paramétrage comportent des notices, des emprunteurs, des auteurs, etc. Pour les supprimer, rien de plus simple, il existe une fonction nettoyage (chemin d’accès : Administration → Outils → Nettoyage de la base).

Lancer la commande en cochant ce qu’il faut retirer pour que la base soit totalement vierge.

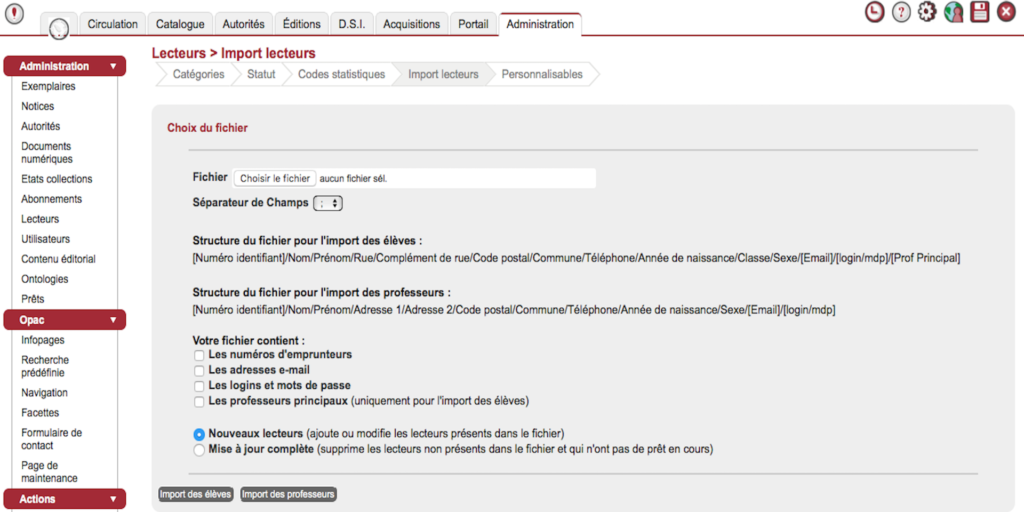

Deuxième étape : vérifier que l’import des lecteurs se passe bien. Pour cela aller dans Administration → Lecteurs → Import lecteurs. Si votre paramétrage de PMB est bon, vous aurez une indication du fichier de bureautique qu’il faut créer (voir image). Je vous conseille de préparer un premier fichier avec une dizaine de lecteurs pour voir si l’import est réalisé correctement et sans problème (opération à répéter jusqu’à ce que votre fichier classeur soit bon en pensant à supprimer les lecteurs précédents).

Troisième étape : avant de faire la bascule de votre base BCDI vers PMB, faire un test avec une petite section de votre base (voir le tuto 1). Aller dans Administration → Imports → Exemplaires UNIMARC et importer. Puis vérifier que cela fonctionne correctement : si les emplacements et le type de prêt sont bons, il ne doit pas y avoir d’erreurs ; sinon, vous devrez peut-être revoir la concordance des champs entre BCDI et PMB (étape 1).

Quatrième étape : faire quelques tests ; prêter des livres à de faux emprunteurs, simuler des retards, essayer d’ajouter des livres et de les prêter, etc. Faire tous les tests qui vous passent par la tête pour être sûr(e) d’avoir une base opérationnelle pour la bascule. Mais avant cela, une dernière manipulation s’impose : nettoyer de nouveau votre base PMB pour éviter d’avoir vos faux emprunteurs et des doublons sur vos ouvrages.

Étape 4 : Bascule et insertion base élève

TUTO 1 : Préparer la base BCDI (Alain Soulier)

C’est la dernière partie et, bonne nouvelle, c’est la plus simple si vous avez bien pris le temps de faire tous les tests. Vous n’avez plus qu’à reprendre les procédures que vous avez déjà faites pour la phase de tests.

Il vous suffit de bien suivre le tuto 1 et de laisser la machine s’occuper de tout ! Il faudra bien sûr faire une vérification générale de ce que vous aurez importé, mais vous aurez un PMB complètement opérationnel !

PMB au quotidien : les avantages !

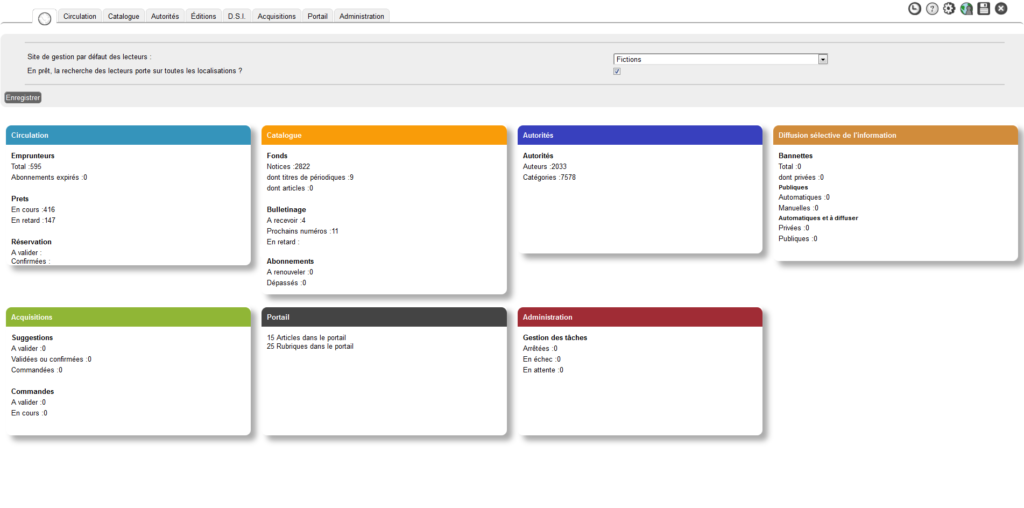

Même si le passage de BCDI à PMB peut sembler complexe, une fois que vous aurez pris en mains cet outil, vous pourrez en apprécier les nombreux avantages. Pour ma part, je constate que j’ai une vision plus globale de l’ensemble de mon fonds, dès la connexion, grâce au tableau de bord (voir image) qui permet de voir en un coup d’œil les retours et/ou les abonnements en retard (oui, il y a beaucoup de retards dans mon établissement…).

PMB permet de prêter des documents tout en continuant le catalogage. Pour cela il suffit d’ouvrir sur différents onglets du navigateur les différents onglets de PMB (circulation, catalogue, ou autre). Ainsi on ne perd pas le bénéfice du travail commencé quand on enregistre un retour à la récréation ou qu’on prête un ouvrage rendu à un élève qui attend pour l’emprunter.

Un autre avantage : l’utilisation des codes-barres avec une douchette (comme dans BCDI). Leur utilisation permet de gérer plus facilement les prêts et surtout les retours, voire de le faire faire à un élève sans que cela soit trop complexe pour lui. Cela représente un gain de temps non négligeable dans nos nombreuses tâches, et il faut l’avouer, certains élèves adorent nous aider !

Je vais maintenant présenter certains aspects de PMB qui facilitent la gestion du fonds au quotidien.

Les paniers

Les paniers sont très utiles lors de recherche « multi-critères », lorsqu’on souhaite réaliser des bibliographies ou des sélections sur un thème, pour préparer l’inventaire ou encore pour avoir une trace des ouvrages à mettre au pilon. Il faut alors veiller à attribuer le résultat de la recherche au panier de son choix (panier « notice », « exemplaire », « bulletin » pour les périodiques, ou « lecteurs », géré sous l’onglet circulation), en cliquant sur l’image du panier correspondant, pour un traitement immédiat ou futur.

Un sous-menu permet de gérer chaque panier : « Gestion » pour créer, modifier ou supprimer un panier, « Collecte » pour remplir le panier, « Pointage » pour distinguer les ouvrages ou ressources d’un panier, et « Actions » pour effectuer un changement sur le contenu d’un panier.

Les paniers permettent de faire un traitement par lots (comme dans BCDI) : soit pour apporter une modification (changement de statut, de section, etc.), soit pour mettre en valeur une partie du fonds sur l’OPAC, soit pour procéder au désherbage, ou au récolement. Pour cette dernière action, il est très utile d’avoir un fonds avec des codes-barres et les douchettes, le pointage devient alors très facile : il suffit de scanner les livres et on voit assez rapidement les ouvrages non « pointés », donc non présents dans le fonds au moment du récolement.

Bulletinage assisté

C’est une fonctionnalité qu’on trouve dans Circulation → Périodiques → Bulletinage. Elle permet, après avoir créé un abonnement avec un modèle prévisionnel pour chaque périodique auquel le CDI est abonné (voir la documentation de PMB pour le tutoriel), de simplement cocher tel ou tel numéro reçu pour lui attribuer un numéro d’exemplaire et le mettre en circulation. Cela permet également de voir assez rapidement les manques dans les abonnements en cours et de faire les démarches nécessaires.

Gestion partagée

PMB permet une démarche partagée de gestion des ressources de l’établissement, ce qui suppose bien évidemment une politique documentaire partagée, impliquant l’ensemble des personnels et portée par le chef d’établissement. Dans une moindre mesure, on peut aussi envisager des profils « utilisateurs » pour des élèves qui apportent leur aide pour les opérations de prêt ou de retours d’ouvrages. Pour cela il suffit d’aller dans Administration → Utilisateurs → Gestion des utilisateurs, et de créer des profils d’utilisateurs (donnant accès à l’interface de gestion) et de leur ouvrir certains droits. Par exemple, dans mon établissement, les élèves du Club Lecture sont formés pour le prêt et le retour des ouvrages : leur profil « Club lecture » leur donne accès uniquement à l’onglet « Circulation », ce qui évite qu’ils fassent des erreurs dans la base même. De la même manière, on peut cataloguer les séries de français et ouvrir le droit de prêt aux collègues de Lettres pour qu’ils gèrent seuls leurs séries.

Dans le cadre de la gestion partagée, j’ai également créé une autre base PMB qui ne contient que les manuels scolaires, de manière à ne pas surcharger la base principale du CDI, mais aussi pour bien dissocier les manuels des ressources du CDI. Avec cette base dédiée, la gestion des manuels scolaires est réalisée avec une rapidité incroyable : les collègues qui veulent les manuels dans leur salle ont un prêt à leur nom et en sont complètement responsables (même pour la gestion des dégradations) ; et le prêt aux élèves est simplifié avec la gestion des groupes classes, il suffit simplement de « biper » les manuels empruntés. En tout, la gestion des manuels en début d’année n’a demandé que 30 minutes par classe. Pour les retours, nous avons décidé avec les professeurs principaux que cela se passerait dans leur salle : j’apporterai la douchette et mon aide.

L’objectif à terme de la démarche engagée avec les collègues est de faire en sorte que les professeurs principaux soient formés et autonomes dans les prêts et retours des manuels scolaires en début et fin d’année scolaire. De mon côté, je n’aurai plus qu’à gérer les arrivées et départs en cours d’année.

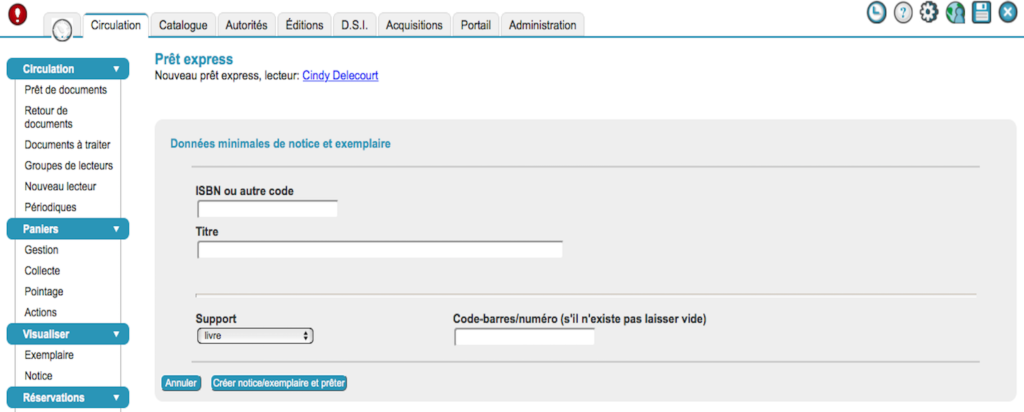

Prêts express

C’est une fonctionnalité de PMB bien pratique quand des élèves attendent impatiemment que les ouvrages soient disponibles au prêt, après une commande. Elle permet de prêter un livre après avoir renseigné seulement un minimum d’informations. Le traitement/catalogage complet se fera une fois que le livre sera rendu. Pour cela, il faut, à partir de la fiche-élève, cliquer sur « Prêt Express ». Et de là, enregistrer l’ISBN, le titre et attribuer un numéro d’exemplaire, puis cliquer sur le bouton « créer la notice/exemplaire et prêter ». Un message apparaît pour signifier qu’il s’agit d’un prêt express. Ce même message apparaîtra au moment du retour pour rappeler qu’il faut alors compléter le traitement documentaire de l’ouvrage.

Au-delà de ces avantages pratiques, il est à noter qu’il existe une grande communauté autour de PMB avec des passionnés qui ont une bonne maîtrise du logiciel. Dès que l’on a un problème technique à résoudre ou une question à propos d’une manipulation, on peut solliciter la communauté PMB : la réponse arrive généralement assez rapidement, d’autant plus que certaines questions ont déjà été anticipées (on n’est pas seul à rencontrer des difficultés). Et le tout avec beaucoup de bienveillance.

« Les défis de l’éducation aux médias et à l’information » selon le CESE

À la différence du rapport Studer2 (Assemblée nationale, octobre 2018) et de la note du Cnesco3 (février 2019), tous deux centrés sur le rôle et la place de l’EMI à l’école, l’avis du CESE entend insister sur le rôle de tous les acteurs de l’EMI (État, collectivités locales, associations, familles…). Voté à l’unanimité, il est en lien avec deux avis précédents, énoncés respectivement en 2017 et en 2019, intitulés : « Réseaux sociaux numériques : comment renforcer l’engagement citoyen ? » et « L’éducation populaire, une exigence du 21ème siècle » lequel évoquait déjà l’investissement de l’éducation populaire dans le champ de l’éducation aux médias et à l’information.

Le CESE énonce ainsi 19 préconisations qui s’articulent autour de trois défis :

– faire de l’EMI une « grande cause nationale » élargie à tous les publics (étudiants, parents, personnes âgées…) ;

– renforcer la formation des acteurs intervenant dans le champ de l’EMI ;

– soutenir l’évaluation et la recherche dans ce champ, notamment autour de la thématique de la réception de l’information. La création d’un fonds financier dédié à l’EMI et abondé par les recettes de la taxe Gafa est envisagée.

Toutes ces perspectives ne peuvent en première lecture que nous enthousiasmer. Pour autant, l’analyse attentive de l’avis et de la synthèse du CESE ainsi que celle des 13 vidéos des auditionnés en entretien public (soit une heure d’audition environ) nous interrogent à plusieurs niveaux.

Notre proposition de lecture critique s’articulera ainsi autour des deux questionnements suivants : quelle est la place des enseignants du secondaire dans l’approche de l’EMI développée par le CESE ? Quelles visions de l’EMI nous sont-elles données à voir à travers le choix et les discours des auditionnés ?

1. Éduquer aux médias et à l’information : où sont les enseignants du secondaire ?

1.1. Une EMI qui échapperait à l’Éducation nationale et à ses acteurs ?

« D’ailleurs comme le souligne le baromètre 2018 sur la confiance des Français dans les médias, 71 % des personnes interrogées estiment que c’est «tout à fait» ou «plutôt» le rôle de l’Éducation nationale d’organiser un enseignement d’EMI à tous les élèves. » (Avis du CESE, p. 31.)

Quelle est l’opinion du CESE sur le rôle de l’Éducation nationale dans l’EMI ? La vidéo introductive de Marie-Pierre Gariel (rapporteure) souligne la multiplicité des actions et des acteurs intervenant dans le champ de l’EMI. La rapporteure insiste également sur le manque de coordination et d’efficacité entre les Ministères. L’analyse lexicale de ses propos relève des références aux acteurs issus de différents secteurs : l’éducation populaire (citée 4 fois), le milieu associatif (cité 4 fois), les journalistes (cités 3 fois). La vidéo introductive comporte enfin des images des membres de l’association d’éducation populaire Jets d’encre participant aux échanges et aux discussions du CESE. Sont nommés d’autres acteurs intervenant dans le champ de l’EMI comme les entreprises du numérique, la Caisse d’allocations familiales (Caf) et l’Union nationale des associations familiales (Unaf) entre autres. Le mot « enseignant » et les actions menées par les enseignants du secondaire sont étonnamment absents du discours de la rapporteure4.

Retour sur l’avis du CESE. Un certain nombre d’éléments sont développés dans la partie intitulée « L’action du ministère de l’Éducation nationale et de la jeunesse » (avis, p. 31), notamment la nécessité de former les enseignants, la place de l’EMI dans les programmes disciplinaires ainsi que celle du professeur documentaliste sur laquelle nous reviendrons dans la sous-partie suivante. Qu’en est-il alors des actions de terrain menées par les enseignants du secondaire après sept années de mise en œuvre de l’EMI ? Qu’en est-il aussi des nouvelles « tendances » d’éducation aux médias et à l’information observées sur le terrain et menées par les enseignants du secondaire telles que les classes média, la réalisation de Booktrailers, de Webradio ou de WebTv par exemple5 ? De tout cela pas un mot, alors que les actions de l’association Jets d’encre, du Bondy Blog (vidéo) et du Labo 148 (avis du CESE, p. 17) ou encore celles du CLEMI qualifié « d’acteur majeur » (avis, p. 37) font l’objet de développements et d’explicitations. Ce constat est, de surcroît, d’autant plus étonnant que l’institutionnalisation de l’EMI dans les programmes des cycles 2, 3 et 4 permet de former plusieurs classes d’âges et que l’avis mentionne d’une part qu’il appartient à l’Éducation nationale « d’organiser un enseignement d’EMI à tous les élèves » (avis, p. 31) et fait référence d’autre part au rapport de l’Unesco6 (2011) qui considère les « enseignants comme des acteurs incontournables pour la promotion de l’EMI » (avis, p. 45). Or, parmi les auditionnés, seule une maîtresse de conférences en SIC7 exprime clairement « le rôle central de l’éducation nationale ». La liste des auditionnés par le CESE (en entretiens publics et privés) atteste par ailleurs d’une sous-représentation des enseignants du secondaire, puisque sur 34 auditionnés : 10 sont issus du milieu associatif dont celui de l’éducation populaire (Jets d’encre, la Zep, le Bondy Blog, Ceméa, l’@gence, Acrimed), 8 sont issus de l’enseignement supérieur (7 enseignants chercheurs, 1 conseillère auprès de la DGESIP), 6 sont issus du secteur de l’audiovisuel et du journalisme (ESJ de Lille, CSA, AFP), 4 représentent les syndicats (SNJ-CGT, CFDT-F3C, CFDT), 2 représentent le CLEMI, 1 auditionné est issu de l’enseignement secondaire (Proviseur de lycée) et 2 auditionnés, enfin, représentent respectivement les Ministères de l’agriculture et de la culture. Mais où sont les enseignants du secondaire ?

Il s’ensuit que le rôle des enseignants du secondaire apparaît seulement en filigrane, à travers l’apport du CLEMI, les partenariats engagés avec le milieu associatif ou à travers la formation. À titre d’exemple, une action d’EMI est évoquée par la rapporteure à travers la Semaine de la presse et des médias. Événement important, certes, mais aussi ponctuel, puisqu’il est limité à une semaine chaque année. Nombre de professeurs n’attendent donc pas cet événement pour mettre en place leurs actions d’EMI sur l’année en fonction des programmes scolaires et des opportunités qui s’offriront à eux. Et lorsqu’il est question enfin de favoriser une EMI active, ce n’est pas non plus dans le champ de l’Éducation nationale que les références sont prises, puisqu’il s’agit de développer « une pédagogie de l’apprentissage par le «faire» qui utilise notamment les méthodes actives de l’éducation populaire » (avis, p. 49). Alors que le CESE développe une approche de l’EMI sous l’angle de la citoyenneté, de l’éducation critique et de la préservation de la démocratie, comment élargir l’EMI à tous les publics tout au long de la vie en occultant à ce point l’engagement et le travail mené par les enseignants du secondaire ?

1.2. Focus sur le professeur documentaliste : le rattachement de l’EMI aux SIC

« Je pense à l’existence de professeurs documentalistes qui sont formés aux SIC […] je pense à l’existence d’enseignants disciplinaires qui se dévouent à des projets […]. Peut- être faudrait-il permettre aux enseignants documentalistes d’être plus reconnus dans ce rôle central de développement de l’EMI… » Questions à Amandine Kervella (vidéo)8.

Poursuivons nos observations lexicologiques en nous centrant maintenant sur le rôle du professeur documentaliste dans le champ de l’EMI et en partant de l’extrait suivant, issu de l’avis : « Il revient plus particulièrement aux professeurs documentalistes de mettre en œuvre cette éducation soit en propre dans leur CDI, soit dans l’accompagnement de leurs collègues dans les différents champs disciplinaires pour leur permettre de développer des projets » (avis, p. 32). L’expression « en propre » fait référence à la possibilité de mener seul une action d’EMI. Les professeurs documentalistes sont également cités par le Ministère de l’enseignement agricole avec une référence précise à l’enseignement info-documentation à travers le champ disciplinaire de « technologie de l’information et du multimédia/information-documentation » (avis, p. 34). Nous constatons ensuite qu’un certain nombre de verbes sont mobilisés pour signifier le champ d’action de cet enseignant : « maître d’œuvre », « accompagnateur », « il participe aux côtés des enseignants », « il appuie les enseignants » (avis, p. 33 et 59), « il les [les élèves] forme à un usage raisonné et critique des ressources médiatiques numériques et physiques » (avis, p. 33). De l’accompagnateur au formateur en passant par le maître d’œuvre, il s’avère que l’utilisation d’une multiplicité de verbes pour qualifier les missions du professeur documentaliste accentue le manque de visibilité sur sa fonction pédagogique. L’avis évoque, pour preuve, l’implication du professeur documentaliste également en ces termes : « Mais ils et elles [professeurs documentalistes] ont aussi d’autres missions et parfois du mal à dégager du temps notamment pour monter des projets d’EMI en partenariat avec des acteurs extérieurs » (avis, p. 60). C’est ignorer la priorité accordée à la transmission d’une culture de l’information et des médias qui se manifeste sur le terrain à travers les nombreuses actions d’EMI menées seul ou en partenariat. Cette priorité accordée à l’expertise pédagogique du professeur documentaliste dans le champ l’EMI s’inscrit dans le premier axe de la circulaire de mission professionnelle de mars 2017, pourtant citée dans l’avis du CESE.

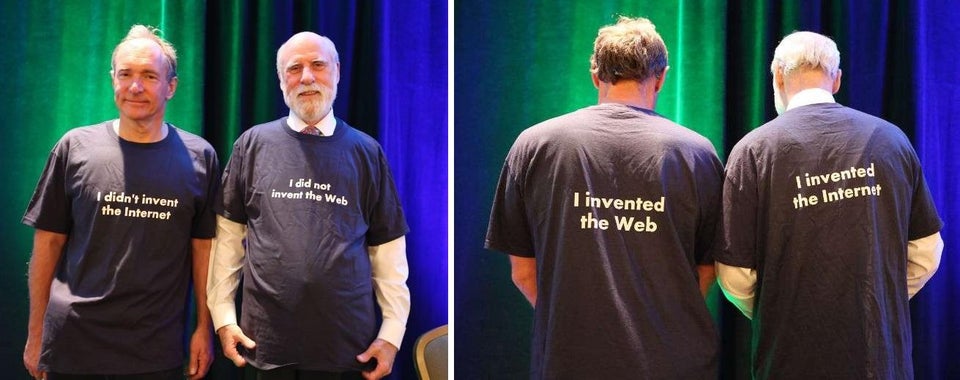

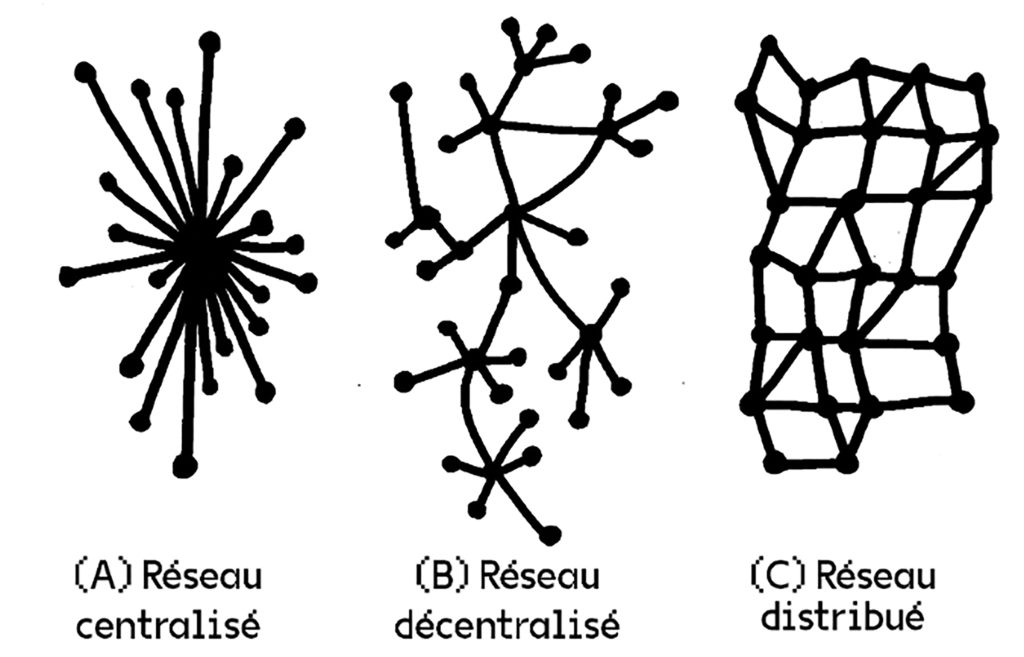

La préconisation n° 159 suggère un renforcement de la formation initiale et continue des enseignants du secondaire, des professeurs documentalistes, des chefs d’établissements et des personnels du secteur socio-culturel public ou associatif. Dans la même logique, l’avis insiste sur « la formation initiale et continue des enseignants à l’EMI c’est-à-dire a minima aux sciences de l’information et de la communication (SIC) » (avis, p. 60). Cet intérêt des SIC pour l’EMI est également évoqué par Ollivier-Yaniv10 : « l’EMI à la confluence de plusieurs disciplines est plus particulièrement étudiée par les Sic » (avis, p. 35). Alors que les préconisations n° 211 et 612 suggèrent d’une part le renforcement de la marge de manœuvre du CLEMI en tant qu’opérateur de l’EMI (par la création d’instances régionales et nationales pilotées par le CLEMI et réunissant les principaux acteurs de l’EMI), et d’autre part l’augmentation de ses moyens financiers et humains, on ne peut que s’étonner que l’augmentation du champ d’action pour les enseignants du secondaire, et surtout pour les professeurs documentalistes qui appartiennent aux champs des SIC, ne fasse pas l’objet d’une préconisation du CESE. L’avis énonce enfin que « dans les nouveaux programmes, la place des professeurs documentalistes est réaffirmée » (avis, p. 33). Il est fait référence ici aux nouveaux programmes de lycée où ce n’est pas la place du professeur documentaliste qui est réaffirmée mais celle des notions info-documentaires. Auparavant ces notions invisibles étaient diluées dans les programmes disciplinaires. La réforme du lycée 2019 marque en effet un recentrage de ces notions info-documentaires autour d’objets d’études abordés selon les épistémologies disciplinaires. En voici trois exemples : le premier concerne le thème 4 du programme d’enseignement de spécialité d’histoire-géographie, géopolitique et de sciences politiques en classe de 1ère intitulé « s’informer : un regard critique sur les sources et modes de communication » (25 h) ; le second exemple extrait du programme de français de la classe de 2nde bac professionnel concerne l’objet d’étude nommé « la construction de l’information : s’informer » qui s’articule autour des thématiques des circuits de l’information, des médias, de la source et du système de la désinformation ; enfin les objets d’études relatifs au programme de SNT (sciences numériques et technologie) de la classe de seconde ont trait à internet, au web (histoire, fonctionnement, moteur de recherche), aux données (définition, structure et enjeux), aux réseaux sociaux (définition, enjeux, cyberviolence…) entre autres.

Et nous pourrions aller plus loin dans l’analyse de ce qui constitue in fine des parties de « programme disciplinaire » en information-documentation-média. Ce « programme » se constitue progressivement face aux nouveaux enjeux sociétaux liés à la société de l’information, sur un mode transversal, et de manière éclatée. Ces évolutions ouvrent assurément de nouvelles perspectives pour le professeur documentaliste qui voit son champ d’action s’accroître en fonction de la réalité des terrains. Peut-on dire pour autant et de manière généralisée que « la place des professeurs documentalistes est réaffirmée » ? Un professeur documentaliste qui prendrait en charge le programme de SNT en classe de 2nde par exemple serait indubitablement confronté aux mêmes logiques contradictoires : accueil des élèves au CDI/enseignement selon un emploi du temps défini, notions info-documentaires abordées sous l’angle des disciplines/ notions info-documentaires abordées sous l’angle des SIC, pour ne prendre que ces deux exemples.

2. L’EMI et le développement d’un « agir responsable » face à l’information et aux médias

2.1. Le paradoxe de l’élargissement de l’EMI à tous les publics

« L’EMI doit permettre aux enfants, aux jeunes, aux adultes et aux personnes âgées, d’acquérir, sans pour autant devenir des professionnels, des connaissances et des compétences leur permettant de s’informer, d’émettre, de diffuser, d’analyser et de partager des informations de façon responsable. » (Synthèse du CESE, p. 1.)

Face aux nouveaux modes d’accès à l’information, la nécessité d’élargir l’EMI à tous les publics tout au long de la vie fait consensus. Le statut de l’EMI dans la sphère scolaire est rappelé par le CESE : enseignement transversal (et non discipline scolaire) qui repose sur une démarche active et sur une pédagogie de projets (avis, p. 32) qui tiennent compte des pratiques réelles des acteurs. La préconisation n° 413 évoque enfin la mise en œuvre d’un plan systématisant la création d’un média par établissement scolaire et propose la mise en place d’événements liés à l’EMI.

La volonté d’élargir l’EMI à tous les publics cible essentiellement les parents, les étudiants et les personnes âgées et prévoit l’élargissement du champ d’action de divers acteurs du milieu socio-culturel. La préconisation n° 6 prévoit par exemple une Semaine de la presse et des médias renommée en « semaine des médias et de l’information pour tous » avec un volet scolaire et un volet grand public. Alors que l’EMI est institutionnalisée dans les programmes des cycles 2 (CP, CE1, CE2), 3 (CM1 et CM2) et 4 (5e, 4e, et 3e), il est étonnant qu’une préconisation visant à élargir institutionnellement l’EMI au lycée ne soit pas formulée. Comment raisonnablement construire une EMI « tout au long de la vie » élargie à tous les publics sans une institutionnalisation de l’EMI à tous les niveaux scolaires ?

La citation ci-dessus rappelle la finalité de l’EMI dans la formation du citoyen responsable. L’analyse de l’avis du CESE atteste par ailleurs d’une insistance lexicale autour de la notion de « responsabilité » : « […] accéder à une autonomie responsable » (avis, p. 10), « être libres et responsables face à l’information en contribuant à un débat démocratique et éclairé » (avis, p. 11), « exercer sa citoyenneté de façon responsable et informée » (avis, p. 48). La responsabilité constitue une charge à assumer pour l’élève et sous-tend un certain nombre de capacités pour répondre de ses actes en tant que producteur et consommateur d’information. Le développement des techniques numériques impose en effet une responsabilité constitutive de l’action : vérifier les sources, analyser la véracité de l’information, diffuser une information fiable en tant que producteur par exemple. La responsabilité est constitutive enfin de la liberté, puisqu’être libre c’est être en mesure d’assumer ses responsabilités. Cette approche responsabilisante (avis, p. 13) qui selon Yolande Maury (2011) vise « à ce que l’élève soit en capacité d’assumer les changements, de gérer aléas et incertitudes, et résoudre lui-même les défis et/ou problèmes rencontrés »14 n’est-t-elle pas un moyen pour l’institution de se désengager de ses responsabilités en matière d’EMI ? Renvoyer aux responsabilités de chacun, c’est éviter de se confronter à la sienne.

Or, développer un agir responsable à l’égard de l’information et des médias induit pour l’élève la capacité de comprendre, d’analyser, de critiquer, de proposer et de décider dans l’environnement informationnel numérique. Pour les enseignants, éduquer à la responsabilité dans l’usage de l’information et des médias sous-tend la transmission d’un minimum vital informationnel, fondé sur des connaissances et des compétences info-documentaires autorisant le développement du sens de la responsabilité chez l’élève ; « une bible informationnelle » écrivait Claude Baltz15. Le développement d’un agir responsable va toutefois bien au-delà d’un volet de connaissances et de compétences à transmettre. Il sous-tend une façon de percevoir le monde informationnel à l’ère numérique, une manière d’être et d’agir sur ce monde. Claude Baltz l’affirmait déjà en 1998 : « pas de société de l’information sans culture informationnelle »16. L’agir responsable est au cœur de la transmission d’une culture informationnelle fondée sur une éthique de l’information et des médias, sans laquelle l’élève ne peut développer ses capacités dans la société d’aujourd’hui où le numérique prend une place majeure.

Le développement de cet agir responsable est-il toutefois possible sans la reconnaissance pleine et entière des actions d’EMI menées par les enseignants du secondaire ? Est-il possible sans une reconnaissance institutionnelle ferme et sans équivoque du mandat pédagogique du professeur documentaliste qui, fort de son expertise pédagogique dans le champ des SIC, a la charge de transmettre cette culture informationnelle, de la même manière qu’il appartient à un professeur de sciences de transmettre une culture scientifique, à un professeur de lettres de transmettre une culture littéraire ou à un professeur d’histoire-géographie de transmettre une culture humaniste ?

2.2. L’EMI, à la convergence de trois éducations à… (information, média, numérique) : l’information à l’épreuve du média

« Je parlerai surtout de l’information parce que lorsque l’on entend média, il y a aussi du divertissement […] l’important c’est l’information. […] ça nécessite de l’éducation à l’information plus que de l’éducation aux médias. » Questions à Patrick Eveno (vidéo)17.

Les 19 préconisations du CESE plaident « pour une EMI élargie qui accompagne les individus tout au long de leur vie dans l’acquisition d’une solide culture médiatique et numérique » (avis, p. 48). Lexicalement, les termes relatifs au champ médiatique sont sur-représentés par rapport au champ de l’information-documentation. Ce qui ne signifie pas pour autant que ce dernier soit inexistant, mais qu’il souffre plutôt d’un manque de visibilité. Deux exemples extraits de l’analyse lexicale des travaux du CESE autorisent ce constat. Le premier est issu de l’analyse des vidéos des auditionnés qui révèle plusieurs formulations de l’EMI : l’« éducation aux médias » est l’expression la plus utilisée (31 fois) par les auditionnés. C’est deux fois plus que l’expression pourtant « officielle » d’« éducation aux médias et à l’information » ou « EMI » formulée 15 fois par les auditionnés. L’expression « éducation à l’information » est quant à elle peu employée (3 fois) tout comme « éducation ou formation au numérique » (7 fois). L’analyse lexicale des discours des auditionnés révèle pourtant clairement la présence de notions relatives aux champs de l’information-documentation : 89 récurrences de termes issus du champ lexical des médias ont été relevées (média et médiatique essentiellement) et 81 sont relatives au champ lexical de l’information (informer, information, source, désinformation, infox, fake essentiellement).

Le même constat apparaît à travers l’analyse de l’avis du CESE. L’éducation aux médias (EAM) est évoquée à travers huit approches et en termes :

– d’évolutions, d’histoire et de bouleversements (mutation du monde des médias, crise des médias, confiance et méfiance vis-à-vis des médias, histoire des médias…) ;

– de modèle et de sphère économique propre (organisations professionnelles du secteur de la presse et des médias, concentration des médias, élargissement de l’offre médiatique, modèle économique des médias, condition de travail dans les médias…) ;

– de diversité (médias traditionnels, audiovisuels, média « pure player », média alternatif, médias associatifs) ;

– d’usage et d’appropriation (pratiques médiatiques, création de média, fabrication de contenu médiatique, décrypter les médias et l’information, décrypter les messages et les représentations médiatiques) ;

– de culture (une solide culture médiatique et numérique, culture des médias et du numérique).

La perte progressive du mot « information » dans l’expression « éducation aux médias et à l’information » formulée par les auditionnés et la faiblesse des occurrences liées à l’expression « éducation à l’information » n’empêchent pas une nette représentation de l’éducation à l’information (EAI) à travers six approches et en termes :

– d’évolutions, d’histoire et de bouleversements (fausses informations durant la grande guerre, diffusion et circulation de l’information, nouveaux vecteurs d’information, flux d’information désormais continu, instantané et planétaire, de nouveaux moyens de diffusion de l’information, changement dans la façon de produire et transmettre de l’info, histoire de l’information…) ;

– d’usage et d’appropriation surtout (décryptage et réception de l’information, émetteur et récepteur de l’information, s’informer, analyser et partager des informations, traitement de l’information, le rapport à l’information, crédibilité et pertinence d’une information, sources d’information, qualité de l’information, consommation d’information, comprendre l’information, ressources documentaires et informationnelles, appropriation de l’environnement informationnel, recherche d’information, évaluation de l’information, l’évolution de la société de l’information, nouveaux usages des jeunes en matière informationnelle, maitrise de l’info, accès à l’information, manipulation de l’information, exposition à une information…) ;

– de diversité (désinformation, multiplication des supports d’information, l’information d’actualité, sites d’information, informations peu fiables, mal-information…) ;

– de modèle et de sphère économique propre (dégradation des conditions de travail et précarisation des professionnels de l’information, technologies de l’information, associations de professionnels de l’information…) ;

– d’éthique (droit à l’information, libertés de l’information, esprit critique face à l’information, crédibilité de l’info, confiance dans les informations, pluralisme de l’information…).

L’indicible « éducation à l’information » diluée dans les expressions « éducation aux médias et au numérique » constitue bien par conséquent un champ spécifique, distinct, et possède un territoire propre, mais cette éducation à l’information souffre d’un manque de visibilité renforçant sans doute son caractère indicible.

Conclusion

« […] inscrire l’EMI dans un parcours et dans un temps long plutôt que dans la multiplication de séquences (ateliers ou interventions ponctuelles) dont les effets sur les bénéficiaires sont limités. » (Avis, p. 49.)

En touchant toute une classe d’âge par leurs actions pédagogiques, les enseignants restent les acteurs principaux de la mise en œuvre de l’EMI. Leur sous-représentation dans les travaux entrepris par le CESE est-elle révélatrice d’un aveu d’impuissance de l’école dans la mise en œuvre d’une EMI pour tous ? L’inscription de l’EMI dans un temps long comme l’énonce la citation ci-dessus extraite de l’avis du CESE est-elle compatible, par exemple, avec d’une part l’absence de reconnaissance institutionnelle de l’EMI à tous les niveaux de l’enseignement secondaire et d’autre part avec la « forme scolaire » ? Cette dernière expression employée par de nombreux chercheurs dont Jean-François Cerisier (2016) désigne cet espace où « on n’y apprend ni ce que l’on veut, ni à sa façon, et l’on ne choisit ni avec qui, ni où, ni quand » (Cerisier, 2016, p. 10)18. Dans cet ordre scolaire qui a son organisation temporelle propre (découpage en temps de cours) une EMI inscrite dans un temps long pourrait-elle trouver sa place ? N’y a-t-il pas ici une incompatibilité ? Beaucoup de questions sont formulées qui restent pour un temps sans réponse. Le travail mené par le CESE, certes, encourageant pour la profession, atteste en conclusion d’un manque de visibilité, voire d’une forme de méfiance vis-à-vis des actions d’EMI menées dans la sphère de l’enseignement secondaire. L’EMI vue par le CESE n’est pas l’EMI que les professeurs documentalistes mènent au quotidien, confrontés aux problèmes et aux questions info-communicationnelles des élèves.

Or, nous sommes l’institution scolaire : élèves, enseignants, parents… Par notre implication et nos intentions, nous contribuons à bâtir l’institution scolaire. Pour mener à bien leurs actions visant à développer chez l’élève un agir responsable à l’égard de l’information et des médias numériques, les professeurs documentalistes pourraient se focaliser essentiellement sur leur mission pédagogique. Mission prioritaire qui reviendrait dans certains contextes à accepter et à autoriser que d’autres personnels (enseignants, élèves…) puissent prendre en charge les missions de gestion et d’accueil du CDI. Dans un espace-temps bouleversé par le numérique et face à une information circulante, se délocaliser, quitter le CDI pour éduquer à l’information et aux médias et transmettre les fondements d’une culture informationnelle m’apparaissent comme une nécessité. Cette délocalisation, ce hors-lieu, garantirait l’avenir pédagogique des professeurs documentalistes qui ne se situe plus à l’intérieur du CDI mais dans chaque espace de l’établissement scolaire.

Sexualité et littérature ados

L’adolescence est un âge de la vie qui correspond à peu près à la période de la puberté chez l’homme. Elle se caractérise par des transformations psychologiques et physiques qui le font passer de l’enfant à l’adulte ; l’être humain devient sexué et capable de se reproduire. D’où la place importante que prennent le sexe et la sexualité chez les ados. Même s’ils sont ressentis de manière plus forte, les sentiments tels que l’amour, l’amitié, l’injustice ont déjà été éprouvés par les enfants. En revanche, les émois physiques, aussi bien en solitaire que vis-à-vis des autres, sont nouveaux et à apprivoiser. D’autant plus que cette nouveauté, à la fois plaisante, intrigante et effrayante est également taboue. Alors que le corps change, grandit, échappe au contrôle, il est encore difficile de mettre des mots sur les formidables émotions qui le traversent1. C’est là que la littérature intervient : les ados y retrouvent leur questionnement, grâce à votre aide discrète et efficace.

Je vous propose donc un deuxième volet de notre exploration du « roman de genre » : le roman « érotique » pour ados. Nous verrons dans cet article que cet adjectif « érotique » est finalement assez impropre à la littérature ados, mais que je l’emploierai faute de mieux, me refusant d’utiliser le terme « roman sexuel » qui me paraît clinique et à vrai dire assez disgracieux.

La loi du 16 juillet 1949 sur les publications destinées à la jeunesse dit clairement que celles-ci « ne doivent comporter aucun contenu présentant un danger pour la jeunesse en raison de son caractère pornographique […] ». La pornographie, c’est littéralement la représentation de sujets obscènes. Or, la sexualité est considérée comme obscène, et pourtant elle est un des éléments qui façonnent l’adolescence : comment écrire sur un sujet tabou et pourtant fondateur ? Alors qu’aujourd’hui, on parle de sexualité dans les médias, les séries2 , les films, sur Instagram, comment en parler aux ados sans être pornographe ou au contraire, trop didactique ? Suivez le guide à travers le roman « érotique » pour ados.

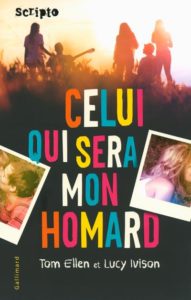

Les premières fois.

Quand on parle d’amour et de sexualité pour les adolescents, on entre dans ce monde troublant et émouvant de la première fois : premier baiser, premiers émois, premières caresses. C’est donc sans surprise dans ce paragraphe que l’on trouvera le plus de références. C’est d’ailleurs le thème du recueil 16 nuances de premières fois, où différents auteurs et autrices jeunesse racontent différentes premières fois, des plus effrayantes aux plus touchantes. Les nouvelles y sont toutefois assez explicites : réservez-le davantage au lycée. Un autre recueil, intitulé Premières fois est à mentionner : des auteurs et autrices abordent des thèmes tels que l’appréhension, les conseils douteux, l’homosexualité, mais aussi la première fois dans d’autres cultures. Un des romans les plus réussis dans cette catégorie est à mon avis L’Amour en chaussettes, de Gudule. Delphine est amoureuse de son prof d’arts plastiques qui, bien sûr, l’éconduit gentiment. Elle se rapprochera de son copain Arthur, avec qui elle fera l’amour pour la première fois. Cette description de la première intimité, avec doux baisers, maladresses et caleçon Simpson est l’une des plus justes que j’aie lue. La question de la première fois, c’est aussi la question du « bon » moment, avec le « bon » partenaire. Faut-il « se réserver » ? Faut-il « se débarrasser » de sa virginité, comme un fardeau encombrant qui nous relie encore à l’enfance ? Deux ouvrages abordent ce sujet, l’un sur un mode léger, façon teen movie américain, et l’autre dans un registre plus ironique. Dans Celui qui sera mon homard, une bande de copines décide que c’est ce soir qu’elles perdront leur virginité ; le tout est raconté dans une ambiance de chassé-croisé léger. Dans J’ai quinze ans et je ne l’ai jamais fait, Capucine, 15 ans, est une jeune fille « intello » et réservée, toutefois obsédée par l’idée de « le faire », si possible avec un garçon plus âgé, le prof d’histoire-géo par exemple… Comme l’héroïne de Gudule, elle finira par se rendre compte que les garçons de son entourage sont plus intéressants qu’ils n’en ont l’air, et que garçons et filles peuvent aussi faire d’autres choses ensemble que simplement perdre leur virginité. Ces titres abordent donc cette question essentielle, avec son lot d’attentes et de déceptions. D’autres romans traitent en revanche des problèmes plus graves liés à la sexualité.

Une thématique couramment abordée est celle de la grossesse adolescente.

Dans Le Test, Madeleine est une jeune fille de bonne famille qui découvre à seize ans qu’elle est enceinte. Au-delà de la question de garder ou non l’enfant, l’autrice Sophie Andrians interroge la question de la communication entre les adultes et les adolescentes, et le fait que tous les milieux sociaux sont concernés. Jo Witek s’empare également de ce sujet dans Trop tôt, où l’on suit la tristement banale histoire de l’amour de vacances d’une très jeune fille : elle fait le mur, elle se sent adulte dans le regard d’un garçon plus âgé, une brève étreinte dans les dunes, et puis le retard, quelques semaines plus tard. On suit sa difficulté de communication avec son père, totalement exclu de ce qui est considéré comme une affaire de femmes, l’avortement.

Un angle plus rare, lié au développement du numérique et surtout à la facilité d’accès aux contenus pornographiques est abordé dans Point of View, de Patrick Bard. Lucas est un jeune garçon plutôt complexé qui va développer une forme de dépendance au porno, au point de se couper de son entourage, voire de se blesser. Il rejoint alors un centre de désintoxication pour adolescents où il rencontre d’autres jeunes aux diverses pathologies, notamment une jeune fille en proie à d’autres démons : ils surmonteront ensemble leurs craintes.

Des tonalités crues.

Des tonalités crues.

Certains auteurs jouent avec les codes du roman ado et cherchent à provoquer des réactions fortes : quoi de plus amusant alors que d’aborder de manière frontale et crue les questions qui taraudent filles et garçons ?

En 2004, l’auteur anglais Melvin Burgess tracassait les bibliothécaires et documentalistes en publiant Une Idée fixe, récit de trois ados qui veulent absolument connaître les joies du sexe, mais sans bien sûr s’y connaître, et en usant et abusant d’un langage extrêmement fleuri. Évidemment, rien ne se passera comme prévu. La description des fanfaronnades des trois garçons est très bien rendue, et rappellera sans doute certaines « grandes gueules », notamment aux profs-docs de collège. Toutefois, c’est le langage qui est cru, et non les situations, ce qui permet à l’ouvrage d’être édité dans une collection jeunesse.

Plus dérangeant était Lady : ma vie de chienne, où une gamine délurée et à la sexualité bien affirmée se retrouvait un matin transformée en chienne (le terme anglais bitch a la même connotation insultante qu’en français) et qui finalement préférait rester ainsi, passant sa journée à traîner avec les chiens du quartier et à manger. Dérangeant par le côté affirmation d’une sexualité bestiale, et surtout du fait de s’en accommoder, ce roman avait beaucoup divisé à sa sortie.

Dans le contexte actuel de libération de la parole, notamment de la sexualité féminine, ces ouvrages ont été réédités par Gallimard.

Plus récemment, Vincent Cuvellier s’amuse avec la fanfaronnade des garçons dans Ma tronche en slip. Ici, Benjamin, 15 ans, un peu vantard, un peu obsédé, assez désagréable finalement, est casté pour des publicités de sous-vêtements. Le périple en Afrique du Sud pour le tournage de la pub est émaillé de gags, de masturbation rapide dans les toilettes pour se calmer après avoir vu les filles en maillot de bain… L’ensemble est assez potache, prête à rire et peut dédramatiser les situations gênantes d’érections impromptues.

Que les expériences vécues soient joyeuses, graves, décevantes ou inexistantes, elles ne sont pas à proprement parler érotiques. Elles cherchent à créer une identification ou au contraire un repoussoir, afin que les jeunes puissent trouver des réponses à leurs questions sur ce moment si intime. Ces situations ne sont pas conçues pour être excitantes.

Toutefois, une collection des éditions Thierry Magnier, L’Ardeur, entend proposer de l’érotisme pour les adolescents. Le premier titre de cette collection s’intitule Le Goût du baiser, de l’autrice Camille Fontaine. L’héroïne, Léa, perd le goût et l’odorat à la suite d’un accident. Elle va devoir apprendre à vivre avec ce handicap, et notamment découvrir la sexualité en étant privée d’une partie de ses sens. Publié en 2019, ce roman balaye tous les sujets qui peuvent intéresser les ados : premier amour, première relation sexuelle, mais également consentement, revenge porn3 , homosexualité, grossophobie, etc. La couverture porte la mention « Public à partir de 15 ans ». En effet, les scènes de sexe sont explicites et visent clairement à émoustiller les jeunes lectrices et lecteurs.

En janvier puis en mars 2020, la collection s’étoffe de deux titres : Le Point sublime, de Manu Causse, et Tout à vous, de Maia Brami.

Cette collection entend mettre la sensualité au cœur de la lecture, et pas seulement la « première fois » comme une étape de l’adolescence.

Si l’on parle de romans érotiques pour les ados, doit-on y inclure les romances, tels les ouvrages du genre After, d’Anna Todd, ou Calendar Girl, d’Audrey Carlan ?

Nombre de jeunes filles (le lectorat de ces ouvrages est majoritairement féminin) lisent ces fictions, qui se trouvent plutôt dans le rayon young adults des librairies. Doit-on les compter parmi les livres à proposer au CDI, vu le succès qu’ils rencontrent, et la thématique qu’ils traitent ? Ici, chacun se fera juge, mais il ne semble pas que ces ouvrages soient destinés à des adolescents : leur contenu explicite4 est clairement destiné à émoustiller les lectrices, et ils ne sont pas publiés sous couvert de la loi de 1949.

Finalement, ce qui lie tous ces romans, et les rend si populaires, c’est qu’ils reprennent la trame du Bildungsroman, le roman d’apprentissage. Ils racontent une des étapes marquantes de la vie des ados, à savoir l’investissement de leurs corps et de leurs sentiments qui deviennent ceux d’adultes. Alors, on peut largement les proposer, car ils ne sont ni érotiques, ni pornographiques. Ils mettent en scène les joies et les affres des cœurs et des corps, et en deviennent par-là universels.

Le mouvement punk

Ressources, partenaires, projets

L’étymologie du mot punk est assez floue. Le terme désigne en Angleterre quelque chose « qui n’a pas de valeur » et aux États-Unis un bon à rien, un paumé. Il est employé dans les années soixante, pour désigner les groupes de rock répétant dans des garages aux États-Unis. En 1971, le critique musical Dave Marsh, est le premier à utiliser le terme de « punk rock » dans la revue Creem. Le mouvement va se développer principalement dans ces deux pays. Contestataire par nature, il s’inscrit dans une période de crise économique. Le punk prospère dans de nombreux squats alternatifs et autogérés, notamment dans le quartier de Hampstead à Londres. En France, le squat de Montreuil, L’Usine, naît en 1980 et prospère jusqu’en 1986. Ces groupes liés à différentes tendances anarchistes (anarcho-punk, peace punk) revendiquent l’autogestion. Le mouvement punk va promouvoir l’amateurisme musical, le do it yourself et la provocation ; dans son sillage, de multiples courants artistiques, tous plus décoiffants les uns que les autres. Une véritable postérité esthétique punk naît, sans cesse renouvelée jusqu’à nos jours.

Don’t be told what you want

Qu’on te dise pas ce que tu veux

Don’t be told that what you need

Qu’on te dise pas ce dont tu as besoin

There’s no future there’s no future

Il n’y a pas de futur Il n’y a pas de futur*

There’s no future for you

Il n’y a pas de futur pour toi

Sex Pistols, God save the queen, 1977

*. Peut aussi se traduire par avenir

Expositions, Archives, musées, Événements

Sacem : Le punk français a 40 ans

Le musée de la SACEM a mis en ligne en 2019 l’exposition Le Punk français a 40 ans réalisée par Mathieu Alterman. Les prémices du mouvement, la première vague punk, le punk populaire dans les années 80, le punk rock alternatif et être punk dans les années 2000. https://musee.sacem.fr/index.php/ExhibitionCMS/ExhibitionCMS/ComplexExhibitions?id=721

Musée du mouvement punk

Site personnel tout à fait dans l’esprit punk

https://www.pinterest.fr/benjaminsueur/mus%C3%A9e-du-mouvement-punk/

Cité de la musique : Europunk

L’exposition temporaire (15/10/2013 au 19/01/2014) présente les créations visuelles de la vague punk apparue dans la seconde moitié des années 1970 au Royaume-Uni, en France et dans d’autres pays. Il est possible de la parcourir en ligne sur le site de la philharmonie de Paris. http://www.citedelamusique.fr/francais/evenements/europunk/europunk.aspx

https://pad.philharmoniedeparis.fr/exposition-europunk.aspx

Musée de la musique à Montluçon, Mupop ; exposition permanente : espace. Les années 80 : local de répétition punk.

https://www.mupop.fr/experience/les-annees-80/

Razibus : site qui annonce tous les événements punk dans l’espace francophone européen.

http://razibus.net/

PIND : acronyme de Punk is not dead est un projet de recherche qui s’inscrit dans le programme « Intelligence des patrimoines », porté par le Centre d’études supérieures de la Renaissance. Il bénéficie actuellement du soutien de l’Agence nationale de la recherche (2016-2020) et de la labellisation 80 ans du CNRS (2019).

http://pind.univ-tours.fr/

Musée des Tissus à Lyon, Vivienne Westwood, à partir du 5 juin 2020.

L’exposition de la collection Lee Price au musée des Tissus de Lyon rend hommage à Vivienne Westwood, une première en France pour la styliste britannique.

www.museedestissus.fr

Exposition Punk graphics, too fast to live, too young to die au musée du design Adam de Bruxelles (20/11/2019 au 26/04/2020). Dossier de presse téléchargeable.

http://adamuseum.be/punk-graphics/

Museum of London, The Clash : London Calling (5/11/2019 au 19/04/2020). Exposition temporaire gratuite. Découvrez la Fender cassée de Paul Simonon, le carnet de Joe Strummer entre autres.

https://www.museumoflondon.org.uk/museum-london/whats-on/exhibitions/london-calling-40-years-clash

Dans les programmes

Collèges

Musique, cycle 4

“Situer et comparer des musiques de styles proches ou éloignés dans l’espace et/ou dans le temps pour construire des repères techniques et culturels”.

Arts plastiques, cycle 4

“Porter un regard curieux et avisé sur son environnement artistique et culturel, proche et lointain”.

Lycée général et technologique, nouveau programme

Seconde et Première, BO spécial n° 1 du 22 janvier 2019

Terminale, BO spécial n° 8 du 25 juillet 2019

https://eduscol.education.fr/pid39038/programmes-et-ressources-voies-generale-et-technologique.html

Philosophie : terminale générale et technologique

Connaissances des doctrines et étude d’œuvre.

Nietzsche, Heidegger : nihilisme.

Diogène de Sinope : cynisme.

Spécialité de management, sciences de gestion et numérique de terminale STMG

“La partie commune du programme apporte des éléments pour comprendre le fonctionnement de tout type d’organisation (entreprises, associations, organisations publiques, organisations de la société civile, organismes, établissements, etc.)”.

SCOP, SCIC → autogestion

Option de management et gestion de seconde

“S’engager et entreprendre, de l’intention à la création.

Notions : Invention/innovation. Idée/production”.

→ Do it yourself

Spécialité de droit et économie, première STMG

“Thème 1 : quelles sont les grandes questions économiques et leurs enjeux actuels ? I.3. Les échanges économiques”.

→ Troc

Langues vivantes (anglais). Première et terminale générales et technologiques

“Formation culturelle et interculturelle. Axe : 3) Art et pouvoir. L’art peut-il être un contre-pouvoir ? L’art est-il une forme d’expression politique ? Mots-clés : … /musique/contre-culture/underground/art engagé …”

Essor du mouvement punk en Grande-Bretagne, lors de la grande récession économique à la fin des années 70’ et début 80’.

Langues vivantes (anglais). Seconde générale et technologique

“Formation culturelle et interculturelle. Axes : 6) La création et le rapport aux arts, 8) Le passé dans le présent”.

Esthétique, musique, art graphique du mouvement punk.

La mode récupère régulièrement les codes esthétiques du mouvement punk.

Musique. Option arts en seconde générale et technologique

“Enjeux et objectifs. Enrichir les pratiques des élèves de références multiples liées à l’esthétique et à l’histoire de la musique, à ses techniques et à ses langages, à sa place et à son rôle dans la société contemporaine.”

“Champs de questionnement. La diversité des esthétiques, des langages et des techniques de la création musicale dans le temps et dans l’espace”.

Musique. Option arts en première et terminale des voies générale et technologique

“Champs de questionnement. La diversité des esthétiques, des langages et des techniques de la création musicale dans le temps et dans l’espace”.

Musique. Spécialité arts en première et terminale de la voie générale

“Champs de questionnement. Culture musicale et artistique dans l’histoire et la géographie”.

Lycée professionnel, nouveau programme

BO spécial n°5 du 11 avril 2019

https://www.education.gouv.fr/pid285/bulletin_officiel.html?pid_bo=38697

Bac professionnel, CAP métiers de la mode ;

Bac professionnel, CAP esthétique, cosmétique parfumerie ;

Bac professionnel, CAP métiers de la coiffure ;

Discipline professionnelle : activités pédagogiques, chefs d’œuvre en lien avec l’anglais et/ou l’histoire.

Pistes pédagogiques

Voyage à Londres : se rendre sur les lieux symboliques du mouvement punk.

Séances pédagogiques en musique : histoire de la musique punk de ses origines jusqu’à aujourd’hui, instruments utilisés.

Laisser le CDI en autogestion aux élèves (lycée uniquement) pendant une journée liée au mouvement punk. Exemple : le jour de la marche des punks du 3 février 1980 à Londres.

Faire des recherches sur les origines de l’explosion du mouvement punk aux USA, en Angleterre, en France en relation avec les programmes (histoire, SES, anglais, musique…).

Recherche sur le nihilisme (philosophie).

Communication : conception d’affiches, flyers punk avec le professeur d’arts plastiques.

Réaliser un fanzine punk dans le cadre de l’éducation aux médias.

Esthétique mode en lycée professionnel, recherches sur le sujet pour un défilé ou pour le chef d’œuvre.

Exposition de documents au CDI (ouvrages, films, affiches).

Diffuser un film sur le sujet puis réaliser un débat.

Mode

La provocation inhérente au punk se retrouve forcément dans cette mode. Il s’agit de choquer et de faire du mauvais goût un signe de distinction. Maquillage noir charbon, cheveux teints en jaune ou en vert, tee-shirt déchiré, parfois maculé de peinture, kilt en tartan, collants filés, lame de rasoir et croix gammée en sautoir, poignets de force, badges accrochés sur un perfecto Schott, creepers ou Doc Martens aux pieds.

La représentante de cette mode est sans conteste Vivienne Westwood qui, avec son mari, le sulfureux producteur des Sex Pistol Malcolm McLaren, ouvre une boutique de vêtements à Londres. Ingénument appelée Sex, cette boutique, dès 1974, reconvertit en vêtements la panoplie en latex du sado-maso jusqu’alors vendue dans les boutiques spécialisées.

Encore aujourd’hui, Vivienne Westwood, poursuit sa carrière de styliste et possède des boutiques dans les beaux quartiers du monde entier (rue Saint Honoré à Paris).

On pourra consulter ce site pour en savoir plus sur la mode punk.

http://histoire-du-costume.blogspot.com/2012/05/le-mouvement-punk.html

Enfin rions un peu, en lisant ce communiqué du Bon Marché (qui porte mal son nom !) pour annoncer son exposition de rentrée en septembre 2019 : intitulée «So Punk Rive Gauche», la grande exposition de rentrée du Bon Marché réveille les codes classiques du grand magasin parisien en mettant à l’honneur à travers ses allées cette contre-culture britannique qui a infusé plusieurs milieux créatifs dans les années 70, musique, cinéma et mode en tête. Du 31 août au 20 octobre 2019, l’adresse de la rive gauche s’attache à célébrer « joyeusement » une certaine idée du punk : « chic, moderne, twisté par une sophistication toute parisienne… sans rien perdre de sa force de subversion ».

À la lecture de ce communiqué, Johnny Rotten et Nancy Spungen ont dû sauter dans leur tombe pour un dernier pogo !

Pour ce faire une idée de l’expo en toute objectivité : Le Moment Meurice sur France Inter : https://www.youtube.com/watch?v=AfeKE7bgWeU

Enfin, le célèbre Tee shirt de Johnny Rotten : I hate Pink Floyd.

Graphisme

Jamie Reid

Artiste graphiste britannique engagé dans le mouvement punk

Réalisation des pochettes des Sex Pistols : l’album Never Mind the Bollocks, Here’s the Sex Pistols et les 45 tours de Anarchy in the UK, God Save The Queen.

Fanzines

De nombreux fanzines rejoignent le mouvement punk

Fanzines punk en France : http://www.fanzino.org/expo_rock/pages/1977.html

Le groupe Bazooka composé de Christian Chapiron (Kiki Picasso), Jean-Louis Dupré (Loulou Picasso), Olivia Clavel (Electric Clito), et Jean Rouzaud va imposer dans la presse ce qu’il appelle une dictature graphique… Le quotidien Libération en 1978 édite, durant six numéros, un mensuel d’actualité, Un Regard moderne, mis en page et illustré par le groupe.

Discographie

Pour devenir sourd

Le top 10 pour se constituer une discothèque punk anglo-saxonne.

The Stooges. – Fun House. 1970

Le groupe d’Iggy Pop est incontestablement considéré comme le précurseur du punk rock. Fun House est le deuxième album du groupe de Détroit qui après s’être séparé en 1974 renaîtra en 2003.

New York Dolls. – New York Dolls. 1973

Cheveux longs, tenues androgynes, les New York Dolls ne portent pas encore la tenue punk, mais leur musique agressive l’est déjà. Johnny Thunders, le guitariste, quitte rapidement le groupe, avec le batteur Gerry Nolan pour fonder The Heartbreakers. Ils participeront en 1976 à l’Anarchy tour avec les Clash et les Sex Pistols.

Patti Smith. – Horses. 1975

Compagne du photographe Robert Mapplethorpe, influencée par Baudelaire et Rimbaud, Patti Smith avec Horses signe un magnifique album qui, s’il n’est pas à proprement dit punk, influencera de nombreux musiciens.

Ramones. – Ramones. 1976

Adossés à un mur en briques, revêtus de perfecto noirs, les Ramones ouvrent leur album éponyme sur BlitzKrieg Bop dont la première phrase Hey Ho, Let’s go ! deviendra le cri de ralliement des jeunes voulant créer leur groupe punk. Un album fulgurant (30 minutes pour 14 titres !).

The Sex Pistols. – Never Mind the Bollocks. Here’s the Sex Pistols.1977

Unique album studio des Sex Pistols. Des musiciens qui ne savent pas jouer, un chanteur, Johnny Rotten, qui ne fait qu’éructer, une pochette moche, un producteur démiurge, Malcolm McLaren : voilà les ingrédients de cet album, climax du mouvement punk.

Richard Hell & The Voidoids. – Blank Generation. 1977

Album phare de la scène new-yorkaise.

The Damned. – Damned, Damned, Damned. 1977

Un album à se damner !

The Clash. – The Clash. 1977

Le groupe londonien est sans conteste le plus politisé de la scène punk. « Nous sommes antifascistes, nous sommes antiviolences, nous sommes anti-racistes et nous sommes procréatifs, et contre l’ignorance » proclame Joe Strummer, le leader du groupe. Un premier album violent et provocateur dans lequel Londres est en flammes.

Siouxsie & The Banshees. – The Scream. 1978

Album à la charnière entre le punk et le post-punk. Un cri !

The Clash. – London calling. 1979

The Clash. – London calling. 1979

Avec ce double album, le groupe, en s’ouvrant au ska, au reggae, au rock, au jazz et à la soul, marque le début du déclin du mouvement punk. Ouvertement anti-Thatcher cet album connaît un succès mondial.

Quant à la France, elle prend le mouvement en route, avec des succès divers qui dépasseront rarement les frontières de l’Hexagone. Parmi les groupes qui émergent à cette époque : Starshooter qui reprend Le poinçonneur des Lilas de Serge Gainsbourg, Les Berurier noirs, anti-fascistes radicaux proches des mouvements autonomes, Bijou qui participa au premier festival punk de Mont de Marsan de 1976, La Souris déglinguée (LSD), Les Wampas qui mirent Chirac en prison en 2006, et Daniel Darc qui se tranchait régulièrement les veines lors de ses concerts.

Métal Urbain. – Les hommes morts sont dangereux. 1981

La Souris déglinguée. – La Souris déglinguée. 1981

Les Béruriers noirs. – Macadam massacre. 1984

Les groupes punk jusqu’à nos jours (liste non exhaustive et à l’avenant) :

À l’étranger : Dropkick Murphys, Converge, Rancid, Bad religion, Pussy Riot, Black flag, Propagandhi, NOFX.

En France : Ludwig von 88, Burning heads, Tagada jones, Guerilla poubelle.

Les mouvements issus de la punk : post punk (Joy Division…), grunge (Nirvana…), hardcore (Dead Kennedys…).

Je suis le maillon faible de votre sous-culture plastique.

Je ne connais rien aux règles

Je me fous de votre esthétique.

Tu m’parles d’la nouvelle star des cons,

j’ai jamais entendu son nom…

Guerilla poubelle, Culture poubelle, 2005

Le professeur-documentaliste de Bernard Heizmann et Élodie Royer

Connaître les champs d’intervention

Ce premier chapitre se divise lui-même en trois parties. La première présente le système éducatif français. Du fait de la « dimension transversale du métier » qui le met en « capacité d’interagir avec tous les acteurs », le professeur-documentaliste a sa place dans les différents conseils, instances et commissions d’un établissement scolaire, du conseil d’administration au conseil de la vie collégienne ou de la vie lycéenne. Sa connaissance des nombreux acteurs du système éducatif, des différents agents d’un établissement en passant par les services rectoraux, sans oublier les collectivités territoriales, lui permet, suivant les auteurs, « d’être plus efficace sur le plan de la communication et de la circulation de l’information » et de « l’élaboration et [du] financement des projets et […] dans [la] recherche de partenariats » (p. 17). La connaissance des programmes et des différentes opérations éducatives jalonnant l’année scolaire permet au professeur-documentaliste d’accomplir ses missions, notamment celle d’enseignement. Ainsi, entre autres, le professeur-documentaliste participe à la maîtrise des compétences du socle commun de connaissances, de compétences et de culture, soit directement parce qu’il intervient auprès des élèves pour travailler l’une ou l’autre des compétences du socle, soit indirectement parce que son travail crée un terrain favorable à leur acquisition (p. 18).

Une deuxième partie traite de la maîtrise de la pédagogie et de la didactique info-documentaires. Après avoir rappelé les principaux textes en vigueur encadrant le métier d’enseignant, Bernard Heizmann et Élodie Royer présentent quelques pédagogues influents, de John Dewey à Jérôme S. Bruner. Le développement d’une « culture pédagogique » étant fondamental pour l’ensemble des missions du professeur-documentaliste, ce rapide descriptif est suivi de celui de concepts pédagogiques, de l’autonomie à la prise en compte des conceptions et représentations des élèves dans l’enseignement. Les deux auteurs présentent les différents types de textes qui encadrent l’intervention pédagogique du professeur-documentaliste : référentiels de compétences, programmes scolaires, curricula et matrices. L’actuel programme d’éducation aux médias et à l’information du cycle 4 ne donnant pas d’indication de progression, il revient « au professeur-documentaliste et aux autres enseignants de fixer celle-ci dans le cadre de la politique documentaire de l’établissement qui formalise la démarche de formation ». Mais, dès lors, plusieurs questions se posent : comment prendre en charge dans un tel cadre tous les élèves ? Quelles compétences peuvent être enseignées de manière partagée avec les collègues de discipline et quelles compétences restent l’apanage du professeur-documentaliste ? (p. 31). Enfin, les auteurs présentent l’évaluation des élèves, sous ses différentes formes (diagnostique, formative, sommative), et la participation du professeur-documentaliste à celle-ci.